- 対象: 全社向け

- テーマ: DX/HRTech

- 更新日:

ChatGPTによる情報漏洩リスクとは?企業がとるべき防止策をご紹介

2022年11月、ChatGPTと呼ばれる人工知能チャットボットがリリースされました。豊富な知識量はもちろん、AIが書いたとは思えない自然な文章の言い回しに世界中が驚嘆したのは記憶に新しいと思います。

その万能さから官公庁をはじめ、さまざまな企業で業務効率化のためにChatGPTが取り入れられています。しかし、適切に利用しないと情報漏洩のリスクもあり、企業にとっては社会的信頼を失う大打撃となる可能性もあります。ChatGPTを適切に利用するためには、ガイドラインの作成などが必要です。

今回は社内で安全にChatGPTを活用するための対策を5つご紹介します。

関連資料

関連資料

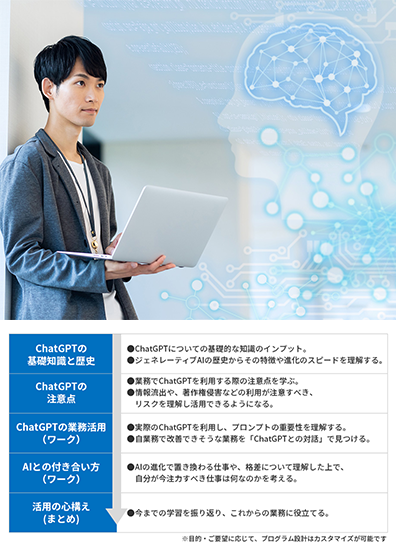

初心者でも苦手意識を持たずに業務で活用できる!

ChatGPTの基礎と業務活用研修

ChatGPTによる情報漏洩リスクとは

ChatGPTによる情報漏洩リスクとしては、社内情報が利用されること、学習した社内データが外部に流出することのふたつが考えられます。

入力内容がAIの学習に利用され、第三者に情報が渡る

開発企業であるOpenAI社(以下OpenAI)は、以下の目的で個人情報を取得し、利用します。

- ChatGPTの提供、管理、維持、分析のため

- ChatGPTを改善し、調査を行うため

- ユーザーとのコミュニケーションのため

- 新しいプログラム及びサービスを開発するため

- ChatGPTの詐欺、犯罪行為、不正使用を防止し、OpenAIのITシステム、アーキテクチャ、及びネットワークのセキュリティを確保するため

- 事業譲渡を行うため

- 法的義務及び法的手続を遵守するとともに、ChatGPTや同社の関連会社、お客様またはそのほかの第三者の権利・プライバシー・安全・財産を保護するため

そのため、ChatGPTに機密情報を入力すると、社外秘が社外サーバーに保存されることになります。ほかのユーザーがChatGPTを利用したときに、情報が返答として使われてしまう可能性も否定できません。

なお、プライバシーポリシーでは、ChatGPT利用時に次の情報が自動取得されることが公言されています。

| ログデータ | インターネットプロトコルアドレスやWebサイトへのリクエスト日時など、利用時にブラウザが自動的に送信する情報。 |

|---|---|

| 利用データ | タイムゾーン、アクセス日時、デバイスの種類、閲覧などをしたコンテンツ、使用した機能、利用者の取った行動などサービス利用に関する情報。 |

| デバイス情報 | デバイス識別子やブラウザの名称などの情報。 |

| クッキー | サービスを運営または管理するためにブラウザに送信される情報の一部。 |

| 分析結果 | クッキーを活用したユーザーの利用状況などのオンライン分析。 |

出典:「プライバシーポリシー」(Open AI)

https://openai.com/ja/policies/privacy-policy

また、法律上の要請のほか、以下のような特定の条件下では、顧客への通知なしに第三者に個人情報を提供する可能性があることも明示されているため留意しましょう。

| ベンダー、サービスプロバイダー | ホスティングサービス、クラウドサービス、分析サービスプロバイダーなど、事業運営において特定のサービスなどを実行するために必要なベンダーなどへの情報提供。 |

|---|---|

| 事業譲渡 | 組織再編などの調査の過程で相手または支援者への情報開示。 |

| 法律上の要請 | 法律により要求された場合、法律に違反すると独自の裁量で判断した場合などでの、政府、同業他社、第三者などへの情報開示。 |

| 関連会社 | OpenAIの関連会社への情報開示。 |

出典:「プライバシーポリシー」(Open AI)

https://openai.com/ja/policies/privacy-policy

学習データがなんらかのトラブルで流出される

ChatGPT利用時の入力データはサーバーに一時的に保存されます。そのため、ChatGPTへの不正アクセスやハッキングなどのトラブルがあったときに情報が流出するリスクがあります。

過去にはChatGPTのバグにより、一部のユーザーにほかのユーザーの履歴が表示されるといったトラブルも生じました。バグ発生からすぐに修正はされましたが、想定外の事故で情報が流出する可能性はあります。

以下は情報流出に関するOpenAIのプライバシーポリシーの一部抜粋です。

"当社は、オンライン及びオフラインの双方において、個人情報を紛失、誤用、不正なアクセス、開示、改ざん、又は破壊から保護するために、商業上合理的な技術的・物理的・組織的措置を講じます。しかし、インターネットや電子メールの送信は、完全に安全でエラーがないわけではありません。特に、当社との間で送受信される電子メールは安全でない場合があります。したがって、本サービス又は電子メールを通じて当社に送信する情報の決定にあたっては、特に注意してください。さらに、当社は、本サービス又は第三者のウェブサイトに含まれるプライバシー設定又はセキュリティ対策の回避について責任を負いません。"

引用:「プライバシーポリシー」(Open AI)

https://openai.com/ja/policies/privacy-policy

プライバシー設定やセキュリティ対策の責任はOpenAIでは負わないこと、ChatGPTで送信するデータの決定は慎重に行うようにと喚起されていることから、情報漏洩防止には利用者側の使い方が重要であることが理解できます。

ChatGPTの活用における情報漏洩の対策5つ

ChatGPTの活用における情報漏洩の対策には、システム面での制御と、使用する社員のリテラシー教育の二方向からのアプローチが有効的です。

DLPを活用する

まず、システム面の制御としてDLP(Date Loss Prevention)の活用があります。DLPとは、データの漏洩や消失を防止する技術のことです。

キーワードやフィンガープリント(デジタル情報がもつ個々を判別する指紋のようなもの)などで、膨大なデータから特定のデータを判別し、情報の監視を行います。

DLPの標準機能は、コンテンツの監視、デバイスの制御、印刷やコピーの制限、Webサイトのアクセス制限、情報漏洩リスクのあるメール送信のブロックです。

これをChatGPTで活用すると、情報漏洩につながる不適切な情報を送信しようとした際、警告と行動制御が行われます。

APIを利用したサービスを使う

API(Application Programming Interface)とは、異なるソフトウェアやWebサービスなどをつなぐためのインターフェースのことです。OpenAIでも、他社のサービスなどにChatGPTを組み込めるように、外部ベンダー向けにChatGPT APIを公開しています。

OpenAIの利用規約において、APIで提供するコンテンツまたは受領したコンテンツをサービスの開発などに利用しないことが明記されています。

つまり、ChatGPT APIを介して入力したデータは再学習されないということです。ChatGPT APIを利用したサービスを導入する、またはAPIを利用して自社システムにChatGPTを組み込むことでこの方法を採用することができます。

利用者以外にアクセス制限をかける

ChatGPTの日本語版サイトには、ユーザーの責任として以下のような記載があります。

"チャットGPTを利用する際には、適切な権限設定やアクセス制限を行い、情報漏えいを防ぐことが重要です。"

引用:「ChatGPTのセキュリティとプライバシー:安全性への取り組み」(ChatGPT日本語版サイト)

https://xn--gpt-1l4bk4a7o.jp/about-chatgpt/about-chatgpt-003/

つまり、ChatGPTを社内で適切に管理するには、使用できるユーザーや機能に一定の制限を設けるべきということです。

具体的な方策として、ChatGPTにできる質問を一定容量に制限する、アクセス権を一部の社員に限定するなどがあります。これらはほかのセキュリティ対策と比べて簡単にできるため、すぐに実践することをおすすめします。

ガイドラインを作る

ChatGPT利用による情報漏洩の防止には、社内で使用ルールを決めておくことも効果的です。例えば、個人情報や機密情報など、万一情報漏洩があった際に企業が損失を受ける可能性のある内容を入力しないなどが挙げられます。

また、チャット履歴をリセットすることで、AIに学習されることを防ぐこともできます。そのため、ガイドラインに「リセット設定の有効化」を加えることも情報漏洩対策としておすすめです。

ただし、OpenAIによる不正利用の調査のために、履歴をオフにしていても30日間はチャット履歴が保存されます。この点も踏まえてルールを設定してきましょう。

以下に、企業におけるAI活用のガイドライン策定事例をご紹介します。

▼クラスメソッド株式会社

同社では、ChatGPT利用のガイドラインとして以下のような内容を規定しています。

- AIサービスの利用は原則として上長の許可を得る

- 業務に直接関連しない情報の入力はOK

- 利用前にデータの取り扱いの規約を確認する

- 業務情報の入力は避ける

- 対策されたサービスやプランでも重大な機密や個人情報の入力は極力避ける

- 文章生成では粗製乱造しない

- コンテンツで利用する際はAI生成であることを明記する など

「クラスメソッド社内のAIサービス利用のガイドラインを策定しました」(Developers.IO)

method.jp/articles/guideline-for-use-of-ai-services/

▼株式会社Zaim

同社では、ChatGPT利用時のガイドラインに、以下の内容を明記しています。

- 利用方法によるデータ取り扱いの区分(極秘、社外秘、公開)・区分別の情報の取り扱い方

(例えば極秘情報はどの利用方法でも利用不可) - AIで出力するデータ利用の注意喚起

- 利用するデータのレベルがわからないときの相談窓口 など

「生成系 AI の業務利用ガイドラインを紹介します」(Zaim スタッフの頭の中)

https://blog.zaim.co.jp/n/n641fc2e19933

ChatGPTの利用における社員教育を行う

ChatGPTでの情報漏洩防止には、導入の推進者、利用者の双方において、使用上のリスクやセキュリティ対策について理解を促すことが重要です。実際に、社員のITリテラシーを高めようと、ChatGPT研修を実施している企業も増えています。

ChatGPT研修では、主に以下のような学習内容が扱われています。

- ChatGPTとは

- ChatGPTの活用事例

- 情報漏洩やセキュリティリスク、またその対策について

- ChatGPTの実践

導入前には、集合研修やセミナー、eラーニングなどを通じて適切な使用方法を学ぶ教育プログラムを社内で体系化しましょう。

まとめ

ChatGPTのようなAI技術は便利である一方、リスクについてもしっかり理解を深めたうえでうまく活用していく必要があります。

JMAM(日本能率協会マネジメントセンター)では、ChatGPTのリスクを理解して安全に利用するための研修を実施しております。まだChatGPTを活用したことのない初心者の方にもわかりやすい内容となっておりますので、ぜひご活用ください。

ChatGPTの基礎と業務活用研修

初心者でも苦手意識を持たずに業務で活用できる!

ChatGPTの基礎知識とともに業務で活用するために必要な視座と具体的な活用方法を学べます。

- 初学者でもわかりやすく基礎から理解できる

- ChatGPTの利用にあたってのルールを理解する

- ワークを通して自業務での活用を考える

関連商品・サービス

あわせて読みたい

Learning Design Members

会員限定コンテンツ

-

多様性を活かし人材の価値を最大限引き出す、生成AIの可能性

多様性を活かし人材の価値を最大限引き出す、生成AIの可能性 -

日清食品ホールディングス|ヘビーユーザーを全社に広げ、創造的活動の時間を生み出す

日清食品ホールディングス|ヘビーユーザーを全社に広げ、創造的活動の時間を生み出す -

NEC|生成AIは人の能力を拡張するツール まずは「活用」する意識へ切り替えを

NEC|生成AIは人の能力を拡張するツール まずは「活用」する意識へ切り替えを

人事のプロになりたい方必見「Learning Design Members」

多様化・複雑化の一途をたどる人材育成や組織開発領域。

情報・交流・相談の「場」を通じて、未来の在り方をともに考え、課題を解決していきたいとの思いから2018年に発足しました。

専門誌『Learning Design』や、会員限定セミナーなど実践に役立つ各種サービスをご提供しています。

- 人材開発専門誌『Learning Design』の最新号からバックナンバーまで読み放題!

- 会員限定セミナー&会員交流会を開催!

- 調査報告書のダウンロード

- 記事会員制度開始!登録3分ですぐに記事が閲覧できます